Вирус с искусственным интеллектом

Обновлено: 19.04.2024

Разработка эффективных вредоносных программ не является чем-то легким и быстрым: эта работа требует навыков и опыта. Хакеры часто являются ИТ-экспертами, используя глубокие знания о компьютерах и сетях для создания совершенно новых вирусов и эксплойтов.

Но там, где ученые используют машинное обучение и искусственный интеллект для диагностики рака или автоматического выявления производственных неисправностей , хакеры используют их для разработки новых вредоносных программ и передовых методов кибер-атак.

Вредоносные программы, расширяющие свои собственные возможности, не являются чем-то новым. Вредоносная программа Olympic Destroyer может обновлять свой собственный исходный код, собирая с взломанных компьютеров учетные данные пользователей. Эти пароли затем могут быть использованы для взлома других компьютеров, позволяя инфекции распространяться по сети.

Несомненно, это умная угроза, но Olympic Destroyer мог только следовать инструкциям, написанным в его исходном коде. Он никогда сам не эволюционировал и не развивал никаких новых способностей по мере своего распространения.

Обладая возможностью изменять свою деятельность, самообучающиеся вредоносные программы будет гораздо труднее обнаружить – особенно учитывая тот факт, что такие угрозы сами смогут обучаться тому, как защищаться от антивирусных и антивредоносных программ.

Такой вид компьютерного вируса звучит как научно-фантастический фильм, но один из влиятельных аналитиков уже предсказывает, что самообучающиеся вредоносные программы к 2024 году будут способны привести к серьезному нарушению баланса в сфере ИТ-безопасности .

На данный момент существует немного доказательств, свидетельствующих о наличии в обращении вредоносных программ на базе искусственного интеллекта. Основные уязвимости системы безопасности ( простые пароли , необновленное программное обеспечение, неэффективные файерволы) значительно облегчают хакерам взлом систем, поэтому им нет необходимости использовать передовые технологии, такие как искусственный интеллект – но это только пока.

К счастью, такие самообучающиеся технологии защиты от вредоносных программ уже существуют и используются для защиты своих пользователей рядом разработчиков решений информационной безопасности , среди которых и компания Panda Security.

Будь в курсе последних новостей из мира гаджетов и технологий

Как искусственный интеллект влияет на будущее вредоносных программ

По мере того, как мы движемся в будущее, с каждым годом перспектива систем управляемых искусственным интеллектом становится более привлекательной. ИИ может помочь в принятии важных решений, управлении энергоэффективности городов и сделает наши фотографии качественнее, но, к сожалению, есть и обратная сторона медали. Искусственный интеллект сможет повысить уровень опасности вредоносного программного обеспечения. Давайте разбираться в возможной роли ИИ для вредоносных программ.

Что представляет собой ИИ для вредоносного софта?

Как ИИ усиливает вредоносное ПО?

Есть несколько способов, как искусственный интеллект может усилить вредоносы. Некоторые из описываемых методов образные, но есть и такие программы, которые уже испытывались практическим применением.

Один из самых страшных примеров вредоносного софта с использованием ИИ — Deeplocker. Эту разновидность программ разработала IBM Research в качестве доказательства своей концепции, поэтому вы не встретите её в обычных условиях.

Адаптивные черви, которые обучаются при обнаружении

Одно из теоретических применений искусственного интеллекта во вредоносном ПО — это червь, который обучается каждый раз, когда антивирус его обнаруживает. Как только он узнает, какие действия приводят к его обнаружению, он прекращает их выполнение и находит другой способ заражения компьютера.

Этот пример особенно опасен, поскольку современные антивирусы, как правило, действуют по определенным правилам. Это означает, что червю нужно найти способ, который не вызовет опасение у антивирусного ПО. Как только это произойдёт, он может сообщить другим штаммам о найденной дыре в системе безопасности, чтобы они начали применять аналогичные методы для заражения других компьютеров.

Независимость от разработчика

Современное вредоносное ПО не может действовать самостоятельно или принимать решения. Оно выполняет ряд задач, которые разработчик заложил в код. Если разработчик хочет, что программное обеспечение сделало что-то новое, то он должен передать список соответствующих инструкций программе.

Слежка за голосами пользователей для получения конфиденциальной информации

В случаях получения вредоносным ПО на основе ИИ контроля над микрофоном цели, оно может прослушивать и записывать, что люди говорят поблизости. Затем искусственный интеллект начинает анализировать услышанное и переводить всё это в текст, который отправляется хакеру. Такой подход облегчает жизнь разработчику программы, избавляя от многочасовой прослушки аудио для поиска коммерческих секретов.

Как ИИ может обучаться?

Вредоносное ПО может учиться на своих действиях посредством машинного обучения. Это особая область искусственного интеллекта полезна для разработчиков, поскольку им не нужно писать дополнительный код для различных сценариев. Таким образом нужно дать знать ИИ, что правильно, а что нет, а затем обучить его методом проб и ошибок.

Искусственный интеллект с функцией машинного обучения при столкновении с препятствием пытается преодолеть его с помощью различных способов. По началу он не справляется с поставленной задачей, но в течение нескольких сеансов обучения и попыток будет учтен негативный опыт для достижения цели.

На видео выше вы можете увидеть пример прогресса. На ролике видно, как ИИ учится правильно ходить различными моделями. Первые шаги выглядят так, как будто модели пьяны, а последние уже передвигаются с уверенностью.

Разработчики вредоносных программ могут использовать мощь машинного обучения, чтобы понять, как правильно атаковать систему. Если что-то пойдёт не так, система отреагирует на ошибку и отметит, что было сделано и, что вызвало проблему. В будущем вредоносное ПО будет адаптировать свои методы атак для достижения наилучших результатов.

Как защищаться от вредоносов с ИИ?

Большая угроза заключается в принципах работы современных антивирусов. Защитное ПО, как правило, работает простыми методами — если программа соответствует определенной базе данных, то такое программное обеспечение будет заблокировано, как вредоносное.

Стоит отметить, что вредоносы, управляемые искусственным интеллектом с функцией машинного обеспечения не будут работать в рамках жестких установленных правил. Они будут постоянно адаптироваться и таким образом смогут функционировать, пока антивирус не получит обновление.

Когда в марте 2020 года вирус поразил Европу, больницы погрузились в новый для себя кризис, не видя путей для выхода. Мы столкнулись с резкой нехваткой знаний. Врачи не понимали, как вести пациентов, фармкомпании думали, как разработать вакцину, государства — как ограничить распространение ковида нанести минимум вреда экономике.

Но существовали данные из Китая, который уже четыре месяца боролся с пандемией. Если бы алгоритмы машинного обучения можно было обучить на этих данных, возможно, врачи и чиновники смогут принимать более взвешенные решения. И это спасет тысячи жизней.

Тогда действительно появлялась масса проектов, стартапов и статей о них. Вот только за март-апрель на Хабре, самые многообещающие:

Больницы были готовы принять любую помощь. Рук не хватало, им нужна была автоматизация. Были разработаны сотни инструментов, от маленьких до гипер-амбициозных. Но ничего почему-то не произошло. Ни один алгоритм не помог.

На помощь врачам тогда пришли исследовательские группы со всего мира. Например, некоторые из них пытались разработать ПО, которое позволило бы быстрее диагностировать пациентов, и отсекать ложные случаи (вот, например, статья о таком ИИ от Alibaba). Были созданы сотни инструментов прогнозирования и диагностики. Но ни один из них не принес той огромной пользы, на которую надеялись. А большинство в итоге оказались даже вредными.

К такому выводу пришел ряд исследований, опубликованных за последние несколько месяцев. В частности, в июне Институт Тьюринга, главный в Великобритании центр по исследованию ИИ, опубликовал отчет (PDF). В нем подводятся итоги процесса внедрения искусственного интеллекта в борьбу с коронавирусом. Их консенсус: инструменты ИИ, если и оказали какое-либо содействие в борьбе с ковид, то крайне незначительное. Несмотря на то, что в эти стартапы инвестировали несколько десятков миллиардов, которые можно было бы потратить на постройку госпиталей и производство аппаратов ИВЛ.

Не подходит для клинического использования

Выводы Института Тьюринга перекликаются с результатами двух других крупных исследований, в которых оценивались сотни инструментов прогнозирования, разработанных в прошлом году. Ведущим автором в одном из них является Лауре Винантс, эпидемиолог Маастрихтского университета в Нидерландах. В исследовании, опубликованном в British Medical Journal, она говорит:

Я возлагала большие надежды на помощь машинного интеллекта. Я подумала, если и есть время, когда ИИ может показать себя, так это сейчас.

Лауре и ее коллеги изучили 232 алгоритма диагностики пациентов или прогнозирования того, насколько больными могут быть люди. Они обнаружили, что ни один из них не пригоден для клинического использования. Ни нашумевшая система, пытающаяся определить коронавирус по голосу. Ни проект, засекающий ковид на рентгеновских снимках. Всего два алгоритма (из 232!) были выделены как достаточно многообещающие для проведения будущих испытаний.

К похожему выводу пришла еще одна группа исследователей во главе с Дереком Дриггсом, исследователем машинного обучения из Кембриджского университета. Их работа опубликована в жунрале Nature Machine Intelligence. Они исследовали модели deep-learning по обнаружению вируса и предсказания рисков для пациента. Были проверены 415 доступных инструмента, разработанных за последние полтора года. Их выводы: ни один из них не пригоден для клинического использования.

Эта пандемия стала большим тестом для ИИ и медицины. Насколько мы готовы к реальному использованию этих IT-инструментов? Полагаю, мы не прошли этот тест.

Что пошло не так

Обе команды обнаружили, что исследователи повторяли одни и те же ошибки при обучении или тестировании своих инструментов. Неправильные предположения об изначальных данных часто означали, что обученные модели не работали так, как заявлено.

Винантс и Дриггс по-прежнему считают, что ИИ может помочь. Но они волнуются о том, что системы могут нанести больше вреда. Сейчас все они могут легко пропустить диагноз или недооценить риск для уязвимых пациентов. Особенно если дело касается групп населения, о которых пока собрано меньше данных: нацменьшинств, детей, людей с хроническими заболеваниями.

Большинство проблем с инструментами связаны низким качеством данных, которые исследователи использовали для их разработки. Информация о пациентах с коронавирусом, в том числе о медицинских сканах, плохо передавалась в разгар глобальной пандемии: у врачей были дела поважнее. В итоге большинство инструментов были созданы с использованием неправильно маркированных данных или данных из неизвестных источников.

Пара забавных случаев

Десятки групп разработчиков использовали набор данных, содержащий сотни тысяч сканов грудной клетки детей, у которых не было ковида, — в качестве примеров того, как выглядят случаи отсутствия короны в людях. В результате их ИИ научились с точностью определять детей, а не вирусов.

Группа Дриггса натренировала модель, используя датасет, содержащий снимки людей, сделанных в положении лежа, и в положении сидя. Казалось бы, какая разница, верно? Но поскольку пациенты, сканированные в положении лежа, с большей вероятностью были серьезно больны, ИИ начал неправильно оценивать риски от коронавируса. Вместо того чтобы анализировать сценарии развития болезни, модель решила предсказывать, будете ли вы лежать или стоять, когда пойдете делать скан легких.

В других случаях было обнаружено, что некоторые ИИ улавливают шрифт текста, который некоторые больницы использовали для маркировки сканированных изображений. В результате сканы из больниц с более серьезной нагрузкой стали предикторами риска заражения коронавирусом. Модели научились прекрасно отличать один шрифт от другого, но ближе к определению ковида это их не привело.

Это всё может показаться забавным. Но, согласно Винантсу, тысячи госпиталей в США, Азии и Европе теперь используют эти модели при работе с пациентами. И даже не сообщают, какие именно из них, поскольку подписывают договоры о неразглашении с поставщиками медицинских ИИ. Когда исследователи спрашивали врачей, какие системы стоят у них на местах, те чаще всего отвечали, что им не разрешено говорить. Поэтому, даже если вы эксперт по ИИ, узнать с какой именно ошибкой алгоритма вы столкнетесь в своей больнице — практически невозможно.

Пути решения проблемы

Получать данные было бы проще, если бы форматы были стандартизированы. Это — задача на следующий раз, для следующего кризиса, решение которого потребует нечеловеческого интеллекта.

Еще одна проблема, которую выделяют Винантс, Дриггс и другие, состоит в том, что большинство исследователей поспешили разработать свои собственные модели, вместо того, чтобы попробовать улучшить уже существующие. В результате коллективными усилиями разработчиков со всего мира были получены сотни посредственных инструментов — а не десяток должным образом обученных и протестированных сисстем.

Модели настолько похожи — почти все они используют одни и те же методы, одинаковые входные данные. И все совершают одни и те же ошибки. Если бы все эти люди, делающие новые модели, вместо этого занимались тестированием тех, которые уже доступны, возможно, сейчас у нас было бы что-то, что действительно могло бы помочь.

В некотором смысле это старая проблема. У программистов и академических исследователей мало карьерных стимулов, чтобы свободно делиться своей работой или просить кого-то подтвердить существующие результаты. Мы привыкли конкурировать с другими, и нам сложно переключиться в другой режим.

Для решения этой проблемы Всемирная организация здравоохранения рассматривает возможность создать стандарт обмена данными в чрезвычайных ситуациях. Он будет вступать в силу во время международных кризисов. Это позволит исследователям легче передавать данные через границы стран и за пределы собственных компаний.

Нам нельзя забыть уроки этой пандемии. Это будет неуважительно по отношению к тем, кто на этот раз ушел из жизни из-за наших ошибок.

P. S. Хотите найти достойную работу? Подключайте телеграм-бот g-mate. Задаете свои преференции, и на вас выходят топовые компании. Не нужно ни резюме, ни портфолио. Настройка занимает меньше 30 секунд.

Уже сейчас понятно, что процессы автоматизации и внедрения машинного обучения в нашу жизнь будут только ускоряться. Алгоритмы не спят, не болеют, быстро проверяют сотни гипотез и находят решения, анализируя огромный объем документов и данных, на который у человека могут уйти годы. Использование анализа данных в борьбе с пандемией — хороший пример, который показывает, как будет выглядеть ближайшее будущее.

1. Помощь в разработке и поиске лекарств

Пока мы разрабатываем новые препараты от коронавируса, можно поискать, какие уже известные лекарства облегчают состояние больных. Тестировать все препараты во всевозможных дозировках и формах слишком долго. Необходимо сузить круг потенциальных лекарств-кандидатов. Для этого нужно отобрать те из них, которые могут хоть как-то помочь при COVID-19.

Много сложных данных — задача для машинного обучения.

Компания Deargen из Южной Кореи разработала модель для поиска соединений, которые борются с вирусом. Она это делает с помощью искусственных нейронных сетей. Эта модель уже определила атазанавир Препарат, который используют для лечения ВИЧ как препарат, который может нанести вред COVID-19. Позже FDA Управление по санитарному надзору за качеством пищевых продуктов и медикаментов США подтвердило, что атазанавир может использоваться в борьбе с COVID-19. В Великобритании другой алгоритм машинного обучения обнаружил, что лекарство от ревматоидного артрита может быть эффективно и при коронавирусе. Но для подтверждения этой теории нужны клинические испытания.

Чтобы разработать вакцину от вируса, необходимо понять его структуру. Сложные органические соединения сворачиваются в причудливые геометрические фигуры, которые влияют на их химические свойства. Чтобы ускорить исследования в этой области, DeepMind опубликовала результаты своей модели, которая прогнозирует структуру белка.

Кто в России будет импортозамещать софт? Каталог ИТ-компаний

Обычно от получения результата до публикации в научном журнале проходят месяцы или годы. Даже если прогноз модели верен, нужно сначала провести серию лабораторных экспериментов, а по их результатам написать научную статью. Еще какое-то время ее будут рецензировать независимые эксперты.

Когда вакцина нужна быстро, такие временные промежутки — неприемлемы. Поэтому инженеры DeepMind опубликовали предсказание своей модели, чтобы другие исследователи использовали эти гипотезы о структуре белка для разработки вакцин. Если модель верна, то эффективная вакцина появится быстрее. Если нет, то ученые, которые взяли их за отправную точку, покажут, что модель ошиблась.

2. Эффективность медицинских учреждений

Анализ развития процессов во времени — отдельный класс задач. Мы называем такие алгоритмы Process Intelligence (или интеллектуальным анализом процессов).

К примеру, они могут по симптомам поступившего пациента предсказать, сколько времени он проведет в больнице, какая помощь ему понадобится и как будет меняться его состояние.

Это помогает оценить количество свободных мест, понять, хватит ли лекарств и врачей на всех пациентов. Если ресурсов недостаточно, можно вовремя вызвать на помощь подкрепление или даже начать строить новый корпус. Данные для таких задач собирают из медицинских информационных систем. В России обработка медицинских данных — новое явление, но в США и Европе электронные медицинские карты существуют уже давно. Такие данные могут быть и у страховых компаний: они получают информацию о выписке пациентов.

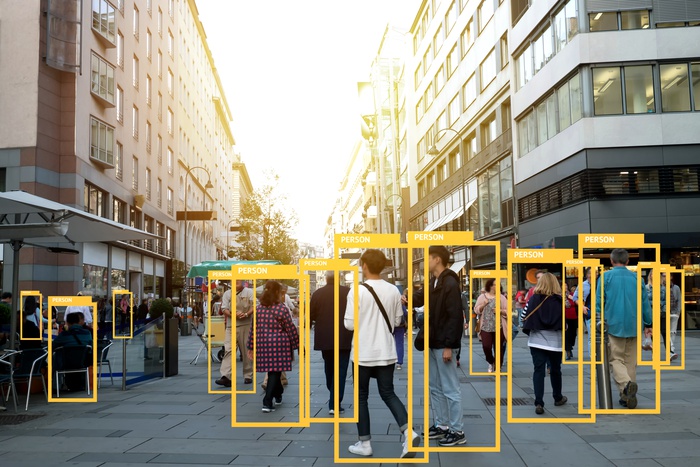

3. Соблюдение социальной дистанции и анализ поведения людей

Социальная дистанция — это одна из мер профилактики распространения инфекции. Компания Landing AI предложила технологию распознавания людей в видеопотоке, чтобы отслеживать соблюдение дистанции. Камера калибрует вход и настраивается на перспективу, а нейронная сеть выделяет каждого человека прямоугольником. Если два таких прямоугольника оказываются слишком близко друг к другу, они подсвечиваются красным. Подобную систему уже использует Amazon, где сотрудников штрафуют за нарушение дистанции.

Со всем, что касается поведения людей, нужно быть очень осторожным. Тут масса вопросов: от этики наблюдения до точности итоговых моделей.

К примеру, когда-то Google c блеском реализовала инструмент Flu Trends для прогнозирования эпидемий гриппа на основе поисковых запросов. Сейчас ученые обсуждают использование данных из социальных сетей для того, чтобы отслеживать географию распространения коронавируса и медикаменты, которые используют люди (особенно те, кто занимается самолечением). Однако тот же Google был вынужден закрыть свой инструмент оценки эпидемий. Когда люди узнали о Flu Trends, он просто перестал работать, потому что вместо поиска тем, связанных с гриппом, пользователи стали заходить на сайт Flu Trends, и модель потеряла свою точность.

4. Другие сферы

Что в итоге?

Все эти примеры иллюстрируют развитие автоматизации и искусственного интеллекта. Во-первых, мы будем больше использовать алгоритмы там, где нужно работать с большими объемами знаний. Систематизация этих данных, обработка и представление в том виде, который будет доступен для автоматического анализа, — большой и важный этап для любой области знания.

Чтобы ваш проект эффективно развивался в будущем, у вас должна быть оцифрованная база знаний.

Во-вторых, мы будем и дальше повышать эффективность процессов за счет машинного обучения и анализа данных. И рутина, и трудоемкая интеллектуальная работа будут автоматизироваться. В-третьих, мы будем использовать решения на основе машинного обучения в разных сферах, включая здоровье и спасение жизней.

Какие методы можно использовать, а какие — нет, какие данные можно собирать, а какие должны остаться за пределами алгоритмов — это этические вопросы использования искусственного интеллекта, на которые разные страны отвечают по-разному. Чья модель окажется более жизнеспособной — покажет время.

Проникновение технологий искусственного интеллекта в область кибербезопасности вызывает серьезную озабоченность.

Автор: Джозеф Чуквубе (предприниматель, специалист по цифровому маркетингу, блогер)

Проникновение технологий искусственного интеллекта в область кибербезопасности вызывает серьезную озабоченность. С одной стороны, технологии ИИ могут использоваться киберзащитниками для смягчения атак и нейтрализации угроз. Однако, оказавшись в руках злоумышленников, технологии ИИ станут опасным оружием и будут представлять серьезную угрозу. По данным BCG, более 90% профессионалов в области кибербезопасности в США и Японии ожидают, что злоумышленники начнут использовать ИИ для проведения атак. По мнению автора, такой сценарий, по сути, уже стал реальностью.

Защищаемся от ИИ с помощью ИИ: решения с поддержкой ИИ для киберугроз нового поколения

При противодействии данной растущей угрозе важно отметить, что для защиты от кибератак с использованием ИИ, требуется применять решения на основе ИИ. То есть там, где дипфейки могут обмануть системы безопасности, должна использоваться более высокая аутентификация на основе искусственного интеллекта. И так далее.

Организации только начинают осознавать риски искусственного интеллекта. Предприятиям следует действовать как можно быстрее, чтобы успеть защитить свои системы от подобных атак. WannaCry вывел кибератаки на совершенно другой уровень сложности. А теперь еще добавился ИИ? Этого нельзя допустить.

Риски ИИ при проведении кибератак

1. Масштабируемость

На конференции Black Hat в 2016 году исследователи представили программу автоматического целевого фишинга. Целевой фишинг, как правило, требует много времени и усилий; в зависимости от масштаба атаки. Злоумышленнику, скорее всего, придется собрать большой объем информации о своих целях для эффективной социальной инженерии. Исследователи продемонстрировали, как большие данные и машинное обучение можно использовать для автоматизации и масштабирования целевых фишинговых атак.

2. Выдача себя за другое лицо

Несколько месяцев назад эксперты Dawes Center for Future Crime назвали дипфейки самой серьезной киберугрозой, связанной с искусственным интеллектом. Нетрудно понять почему. Дипфейки - это инструмент дезинформации, политических манипуляций и обмана. Кроме того, злоумышленники могут использовать дипфейки, чтобы выдать себя за доверенных лиц, взломать деловую электронную почту (голосовой фишинг) для финансового мошенничества. И хуже всего то, что киберпреступников будет трудно обнаружить.

Возможность дипфейка высмеивает саму идею голосовой биометрии и аутентификации. Дипфейки заставят людей не доверять звуковым и визуальным свидетельствам, которые долгое время считались надежными источниками доказательств.

3. Обнаружение-уклонение

Исследования показывают, что заражение всего 3% данных может повысить вероятность ошибки до 91%. ИИ можно использовать как для уклонения от атак, так и для адаптации к защитным механизмам.

4. Изощренность

Выше было рассказано, как ИИ усиливает атаки. Атаки искусственного интеллекта гораздо хуже обычных из-за автоматизации и машинного обучения. Автоматизация преодолевает предел человеческих усилий, в то время как машинное обучение заставляет алгоритмы атак улучшаться на основе опыта и становиться более эффективными, независимо от того, была ли успешной атака.

Адаптивность означает, что атаки на основе ИИ будут становиться все сильнее и опаснее, если не будут разработаны более сильные контр инструменты для сопротивления.

Использование ИИ для защиты от ИИ

А. Машинное обучение для обнаружения угроз

При защите от ИИ с помощью ИИ машинное обучение помогает автоматизировать обнаружение угроз. Особенно это касается новых угроз, от которых не могут защитить традиционные антивирусные системы и брандмауэры. Машинное обучение может на 50–90% сократить количество ложных срабатываний, представляющих серьезную опасность при традиционном обнаружении угроз.

В отличие от инструментов обнаружения предыдущего поколения, основанных на сигнатурах, машинное обучение может отслеживать и регистрировать модели использования сети среди сотрудников в организации и своевременно предупреждать руководителей об обнаружении аномального поведения.

Согласно статистике, в настоящее время 93% SOC используют инструменты искусственного интеллекта и машинного обучения для обнаружения угроз. Из-за увеличения количества данных и роста числа изощренных кибератак специалистам в области безопасности необходимо усилить свои возможности защиты и обнаружения с помощью контролируемого и неконтролируемого машинного обучения.

Б. Улучшение аутентификации с помощью ИИ

Слабая проверка подлинности - наиболее распространенный способ получения несанкционированного доступа к конечным точкам. Как мы видим на примере дипфейков, даже биометрическая аутентификация больше не является панацеей. ИИ дает возможность изощренно обходить защиту, повышая требования к инструментам аутентификации.

Инструменты проверки подлинности, основанные на рисках, (Risk-Based Authentication, RBA) используют поведенческую биометрию на основе искусственного интеллекта для выявления подозрительной активности и предотвращения взлома конечных точек. Затем аутентификация выходит за рамки проверки пользователя до аналитики в реальном времени. RBA, который также называется адаптивным интеллектом, оценивает информацию о местоположении, IP-адрес, информацию об устройстве, конфиденциальность данных и т. д. После этого рассчитывается оценка риска и делается вывод о предоставлении или ограничении доступа.

Например, если человек всегда входит в систему утром в рабочие дни через компьютер в офисе и однажды пытается войти в систему через мобильное устройство в ресторане в выходной, это может являться признаком компрометации, и система должным образом отреагирует на подобное нестандартное поведение.

При использовании интеллектуальной модели безопасности RBA злоумышленнику недостаточно просто знать пароль к системе.

В дополнение к этому, системы аутентификации на основе искусственного интеллекта начинают внедрять непрерывную аутентификацию, продолжая использовать поведенческую аналитику. Вместо одного входа в систему за сеанс, который может быть атакован на полпути, система постоянно работает в фоновом режиме, аутентифицируя пользователя, анализируя пользовательскую среду и поведение на предмет подозрительных шаблонов.

C. ИИ в предотвращении фишинга

ИИ проанализирует стиль письма, синтаксис и выбор слов для выявления противоречий и предотвращения попадания в ловушку, что позволит пользователю безопасно просматривать и скачивать файлы.

ИИ также может сканировать метаданные электронной почты для обнаружения измененных подписей, даже если адрес электронной почты выглядит нормально. Он также сканирует ссылки и изображения, чтобы проверить их подлинность. В отличие от традиционных средств защиты от фишинга, блокирующих вредоносные электронные письма с помощью фильтров, которые легко можно обойти, ИИ выступает непосредственно против самого ядра фишинговых писем: социальной инженерии.

Атаки социальной инженерии трудными для выявления делает то, что они являются психологическими, а не технологическими. До сих пор чистая человеческая смекалка и скептицизм были инструментами для преодоления подобных атак. Теперь ИИ усилил профилактику, расширив пределы человеческих возможностей.

Распознавая закономерности, которые не сразу очевидны для людей, ИИ может определить, является ли электронное письмо вредоносным, даже если оно не содержит подозрительных ссылок или кода. Причем с помощью автоматизации ИИ может это делать в большом масштабе.

D. Предиктивная аналитика

Основным преимуществом ИИ в кибербезопасности является способность прогнозировать атаки и наращивать защиту еще до того, как данные атаки произойдут. ИИ поможет поддерживать полную видимость всей сетевой инфраструктуры организации и анализировать конечные точки для обнаружения возможных уязвимостей. В наш век удаленной работы и использования пользователями собственных устройств для рабочих нужд, когда ИТ-отделы все чаще сталкиваются с трудностями в обеспечении безопасности конечных точек, ИИ может значительно облегчить их работу.

ИИ - лучший выбор против уязвимостей нулевого дня, позволяющий быстро создать интеллектуальную защиту еще до того, как эти уязвимости будут использованы злоумышленниками. Кибербезопасность с использованием ИИ можно назвать чем-то вроде цифровой иммунной системы организации, подобно тому, как человеческие антитела атакуют инородные вещества.

В прошлом году австралийские исследователи обошли знаменитый антивирус Cylance AI, не применяя общепринятый метод отравления наборов данных. Они просто изучили, как работает антивирус, и создали универсальное решение для обхода. Исследование поставило под сомнение практику определения компьютером того, чему следует доверять, а также вызвало сомнения в эффективности использования ИИ для кибербезопасности.

Однако, что более важно, данное исследование показало важность человека. ИИ не является панацеей или серебряной пулей, для борьбы с продвинутыми киберугрозами человеческий контроль по-прежнему необходим. Таким образом мы знаем, что одних человеческих усилий с обычными инструментами кибербезопасности недостаточно для преодоления следующего поколения киберугроз, основанных на искусственном интеллекте.

Не бойтесь использовать технологии ИИ, это лучшее средство нападения и защиты от ИИ.

Один хакер может причинить столько же вреда, сколько 10 000 солдат! Подпишись на наш Телеграм канал, чтобы узнать первым, как выжить в цифровом кошмаре!

Читайте также: